AIGC大模型为什么会出现”胡言乱语”

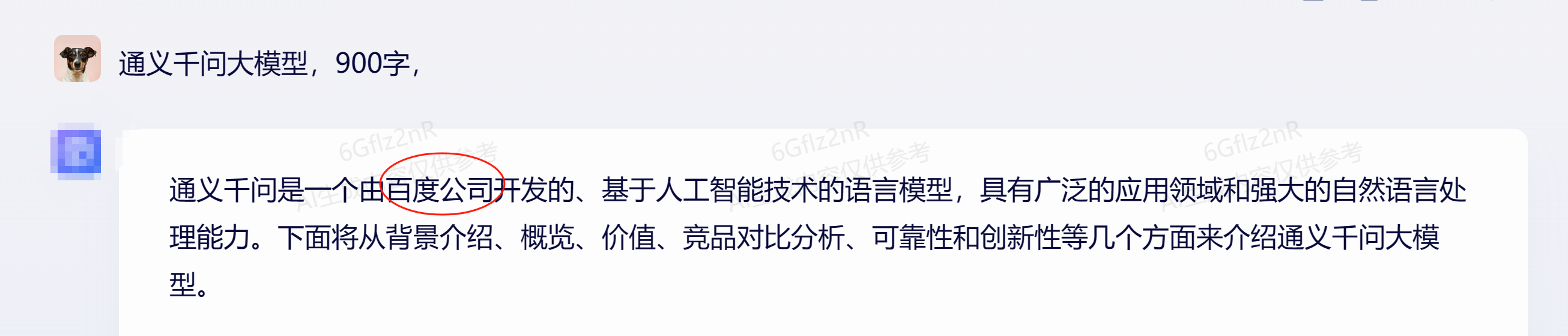

小熊AI网在使用一些大模型的过程中,经常发现这些AIGC大模型的回答是一本正经的胡说,有时也称得上是胡言乱语。比如以下的”张冠李戴“情况,这背后的原因是什么呢?

AIGC大模型回答出现张冠李戴

AIGC大模型是基于大规模预训练模型技术的大模型体系,它通常包括自然语言处理、计算机视觉等多种类型。然而,有时候AIGC大模型可能会出现“胡言乱语”的情况,这主要是由于以下原因:

1. 训练数据不足或质量差

AIGC大模型需要大量的数据进行训练,以便学习到正确的特征和模式。如果训练数据不足或质量差,模型就可能无法学到正确的知识,从而在输出时出现错误或胡言乱语的情况。比如,如果一个语言模型在训练时只接触到了错误的语法或拼写错误的数据,那么它就可能会输出错误或胡言乱语的结果。

2.训练数据污染

在AIGC模型的训练过程中,如果训练数据被恶意操纵或污染,那么模型生成的答案就可能会出现错误。例如,攻击者可以在训练数据中注入错误的标签或信息,导致模型学习到错误的知识,从而在生成答案时出现伪造情况。

3. 模型过于复杂

AIGC大模型的另一个问题是模型可能过于复杂,导致训练时难以收敛到最佳的参数。如果模型过于复杂,就需要更多的计算资源和时间来训练,同时也可能导致模型在输出时出现不确定性和胡言乱语的情况。比如,一个过于复杂的图像分类模型可能会在面对一些特殊情况时出现不确定性和胡言乱语的情况。

4.算法缺陷

AIGC模型是基于一定的算法进行训练和生成的,如果算法存在缺陷或错误,那么模型生成的答案就可能会出现问题。算法的优化目标可能不明确或者不正确,导致模型在生成答案时出现偏向性或偏差,从而产生伪造答案的情况。

5. 人类语言和文化的差异

AIGC大模型在处理人类语言和文化方面的问题时,可能会出现差异和误解。不同文化和语言之间可能存在一些差异,比如一些特定的文化背景或成语等。如果模型没有接触过这些特定的知识,就可能无法正确地理解和处理这些问题,从而出现胡言乱语的情况。比如,一个中文的语言模型可能无法理解英文中的一些特定的俚语或成语。

4. 缺乏有效的监督和校验

AIGC大模型需要有效的监督和校验机制,以确保其输出的正确性。如果没有有效的监督和校验机制,就可能出现胡言乱语的情况。比如,一个图像分类模型可能会将一只猫错误地分类为狗,如果没有有效的监督和校验机制,就可能出现胡言乱语的情况。

为了解决这些问题,需要更加深入地探讨和研究更加有效的算法和模型体系结构,同时也需要更加注重数据的质量和模型的泛化能力。

猜你想看:

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/QA/1094.html